همه چیز درباره فایل robots.txt

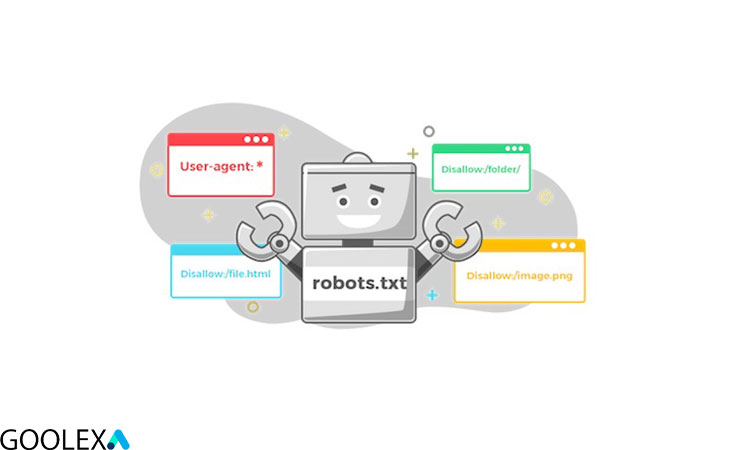

Robots.txtشاید برای شما این سوال به وجود بیاید که فایل robots.txt چیست؟ و یا نحوه ساخت آن چگونه میباشد؟ نقشه سایت یک فایل متنی است که مدیران وب آن را برای موتورهای جستجو ایجاد میکنند که چگونگی کرال کردن صفحات در وبسایتشان مشخص شود. بهتر است بدانید که این فایل شامل دستورالعملهایی مانند رباتهای متا ، دستورالعملهای صفحه، زیردایرکتوری یا سراسر سایت برای نحوه برخورد موتورهای جستجو با لینکها مانند follow یا nofollow است.

به طور کلی فایل robots.txt مجموعه ای از دستورالعمل هایی برای ربات های گوگل است، این فایل مانند هر فایل دیگری در وب سایت بر روی وب سرور میزبانی می شود و برای مشاهده کردن آن در هر سایتی تنها کافی است تا رو به روی URL اصلی سایت خود فایل زیر را اضافه کنید.

/robots.txt

آموزش استفاده از فایل robots.txt

نحوه ساخت فایل robots.txt

باید توجه داشته باشید که ایجاد فایل robots.txt برای هر سایتی الزامی نمیباشد زیرا گوگل میتواند تمام صفحات شما را پیدا کرده و آنها را فهرست بندی کند و صفحاتی را که در سایت شما مهم نیستند و یا تکراری هستند را از لیست خود حذف کنند.

به طور کلی 3 دلیل اصلی برای ایجاد فایل robots.txt وجود دارد که در ادامه مطلب این 3 دلیل را به طور کامل برای شما شرح داده شده است.

نحوه ایجاد نقشه سایت

مسدود کردن صفحات غیر عمومی

گاهی اوقات ممکن است صفحاتی در سایت خود داشته باشید که نمی خواهید ایندکس شوند. به عنوان مثال، ممکن است یک نسخه مرحلهبندی از یک صفحه داشته باشید اما شما نمی خواهید افراد تصادفی روی آنها فرود بیایند، معمولا صفحات ورود به سایت نیز در فایل های robots.txt وجود دارند زیرا با قرار دادن این صفحات در فایل خود میتوانید به مسدود کردن صفحات و جلوگیری از کرال شدن آنها توسط گوگل استفاده کنید.

به عنوان مثال، اگر گولکسا(goolexa) بخواهد ربات ها را از خزیدن این مقاله مسدود کند، چنین دستوری به صورت زیر نوشته می شود:

Disallow: / goolexa / فایل robots.txt چیست؟

پس از دستور “disallow” بخشی از URL صفحه وب که پس از صفحه اصلی قرار می گیرد که در این مورد “www.goolexa.com” قرار می گیرد با این دستور رباتهای گوگل به صفحات غیر عمومی شما دسترسی نخواهند داشت و صفحه در نتایج موتورهای جستجو نشان داده نمیشود.

کاهش کرال کردن سایت توسط خزنده های گوگل

اگر برای ایندکس شدن همه صفحات خود با مشکل مواجه هستید، ممکن است مشکل بودجه خزیدن داشته باشید، با مسدود کردن صفحات بیاهمیت با robots.txt، Googlebot میتواند بیشتر از بودجه خزیدن شما را صرف صفحاتی کند که واقعاً مهم هستند.

مخفی کردن کل وبسایت از گوگل

یکی دیگر از کاربرهای استفاده از فایل robots.txt مخفی کردن کل سایت از گوگل است، توجه داشته باشید که مخفی کردن کل سایت از گوگل به هیچ عنوان توصیه نمیشود، برای انجام این کار تنها کافی است “Disallow: /” بعد از URL سایت خود قرار دهید.

نحوه مخفی کردن سایت از گوگل با استفاده از فایل robots.txt

robots.txt چگونه کار می کند؟

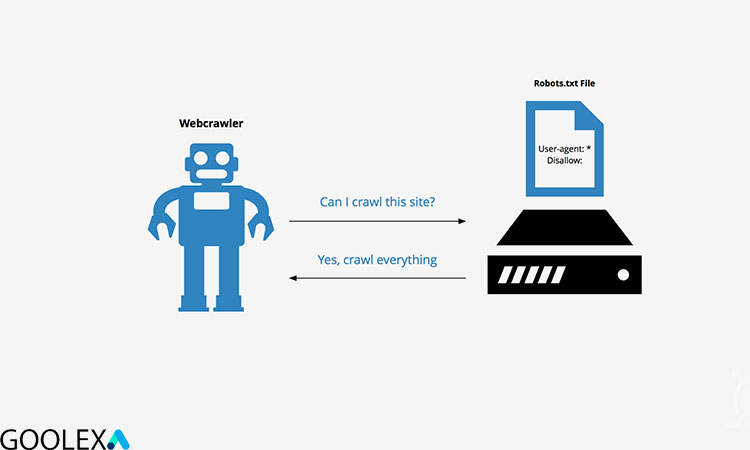

موتورهای جستجو دو کار اصلی دارند که شامل خزیدن در وب برای کشف محتوا و ایندکس کردن آن محتوا به طوری که بتوان آن را برای جستجوگرانی که به دنبال اطلاعات هستند ارائه کرد؛ برای خزیدن کرالرهای گوگل در سایتها، موتورهای جستجو پیوندها را دنبال میکنند تا از یک سایت به سایت دیگر برسند و در نهایت در میان میلیاردها لینک و وبسایت خزیده میشوند.

خزنده جستجو پس از رسیدن به یک وب سایت اما قبل از spider کردن آن، به دنبال فایل robots.txt یا نقشه سایت می گردد. اگر یکی را پیدا کرد، خزنده ابتدا آن فایل را قبل از ادامه صفحه می خواند، از آنجایی که فایل robots.txt حاوی اطلاعاتی در مورد نحوه خزیدن موتور جستجو است؛ اطلاعاتی که در آنجا یافت میشود اقدامات بیشتر خزنده را در این سایت خاص راهنمایی میکند. اگر فایل robots.txt حاوی هیچ دستورالعملی نباشد که فعالیت یک کاربر عامل را ممنوع کند (یا اگر سایت فایل robots.txt نداشته باشد)، به خزیدن اطلاعات دیگر در سایت ادامه خواهد داد.

چرا به robots.txt نیاز دارید؟

فایل های Robots.txt دسترسی خزنده به مناطق خاصی از سایت شما را کنترل می کنند. در حالی که اگر شما به طور تصادفی Googlebot را از خزیدن در کل سایت خود منع کنید، می تواند بسیار خطرناک باشد؛ در مواردی وجود دارد که فایل robots.txt می تواند بسیار مفید باشد. در ادامه برخی از موارد استفاده رایج از فایل Robots.txtشرح داده شده است:

- جلوگیری از نمایش محتوای تکراری در SERP توجه داشته باشید که متا روبات ها اغلب انتخاب بهتری برای این کار هستند.

- تعیین مکان نقشه سایت جلوگیری از ایندکس کردن فایل های خاص در وب سایت شما(تصاویر، PDF و غیره توسط موتورهای جستجو

- تعیین تأخیر خزیدن به منظور جلوگیری از بارگیری بیش از حد سرورهای شما هنگام بارگیری همزمان چند قطعه محتوا توسط خزنده ها

- اگر هیچ ناحیه ای در سایت شما وجود ندارد که بخواهید دسترسی عامل کاربر به آن را کنترل کنید، ممکن است اصلاً به فایل txt نیاز نداشته باشید.

کاربردهای فایل robots.txt

یا همان نقشه سایت

بررسی اینکه آیا فایل robots.txt دارید یا خیر

مطمئن نیستید که فایل robots.txt دارید؟ به سادگی دامنه ریشه خود را تایپ کنید، سپس /robots.txt را به انتهای URL اضافه کنید. برای مثال، فایل روبات های Moz در moz.com/robots.txt قرار دارد. اگر صفحه txt. نمایش داده نشد، در حال حاضر وب سایت شما فایل robots.txt ندارد.

نمونه ای از فایل robots.txt

در ادامه میتواند دو نمونه از فایلهای robots.txt را مشاهده نمایید:

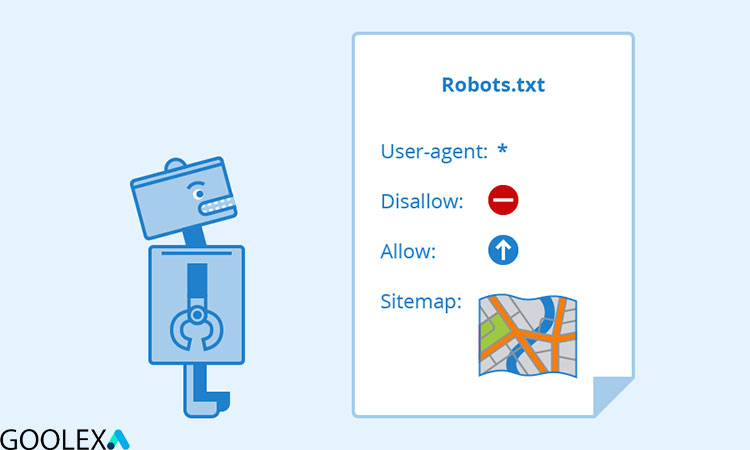

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

——————

User-agent: *Disallow: /wp-admin/Sitemap: https://www.goolexa.com/

نمونه هایی از فایل robots.txt

بدون دیدگاه